下一代人工智能长什么样?可感知和理解行为、解释决策

时间:2021-08-06 21:54:06来源:Lwgzc手游网作者:佚名我要评论 用手机看

扫描二维码随身看资讯

使用手机 二维码应用 扫描右侧二维码,您可以

1. 在手机上细细品读~

2. 分享给您的微信好友或朋友圈~

下一代人工智能是什么样的?

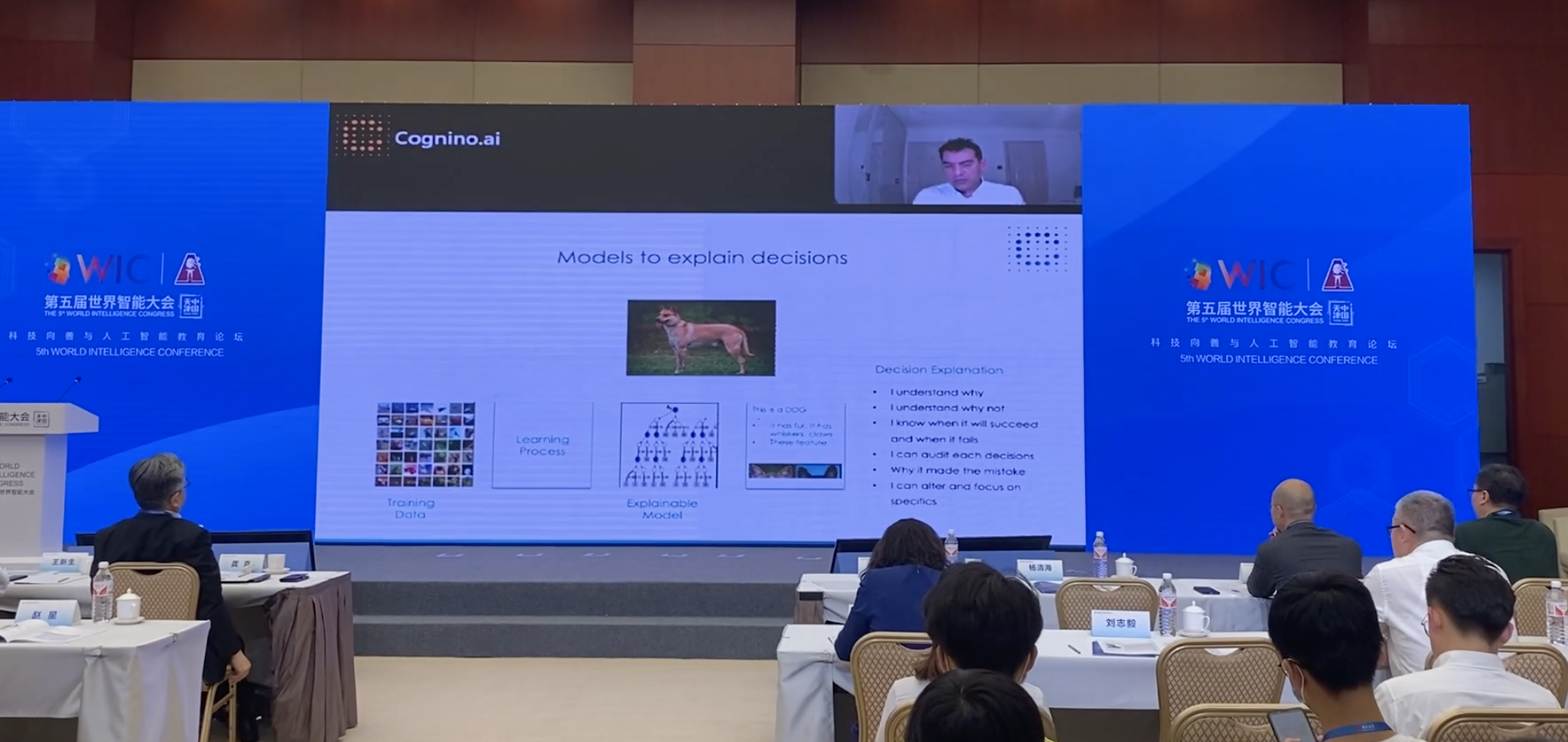

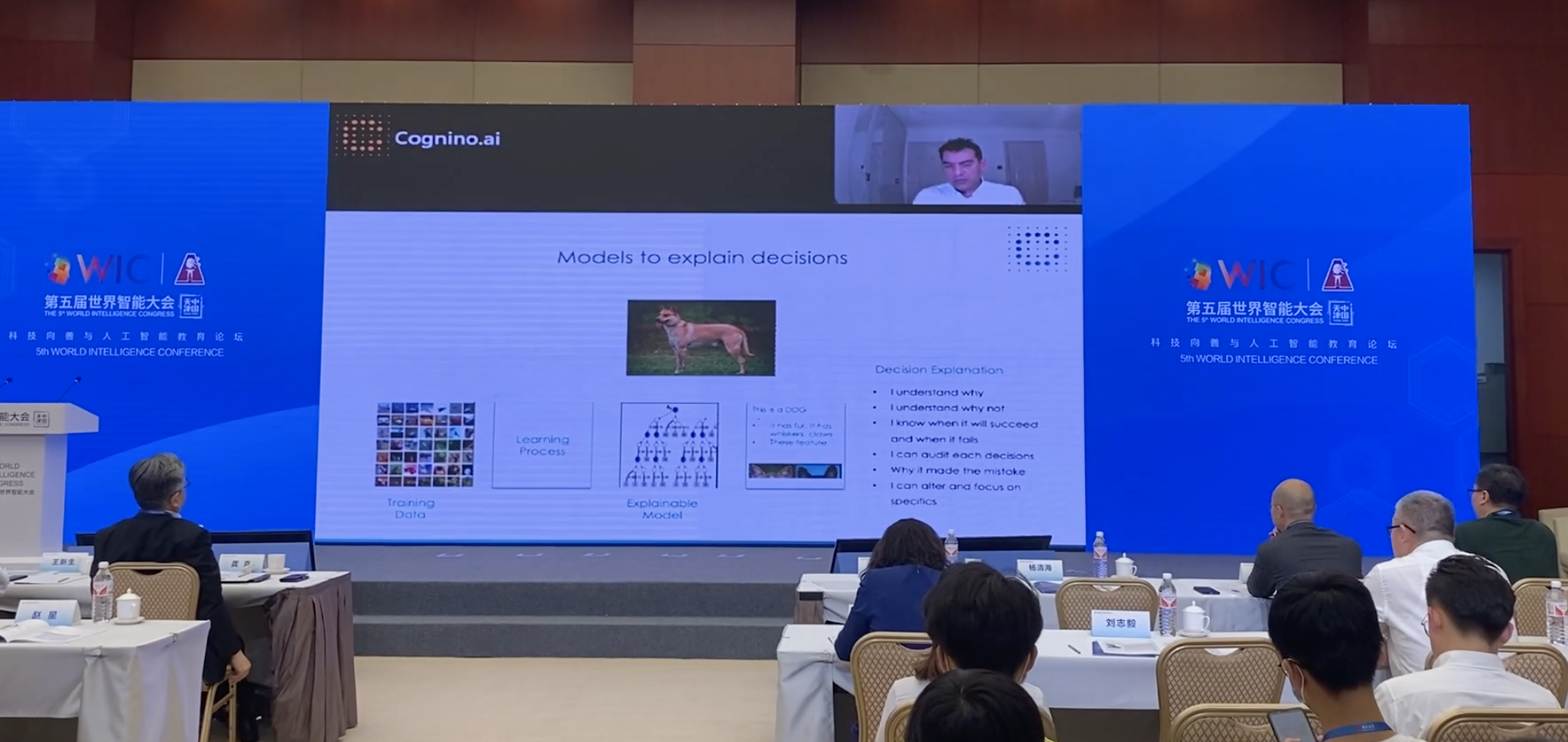

5月21日,英国初创公司Cognino AI联合创始人兼首席执行官普里蒂·帕迪(Priti Padhy)在第五届世界智能大会科技向善与人工智能教育论坛上通过视频表示,在下一波人工智能浪潮中,AI必须具有感知和理解行为的能力,利用人类理解语言的能力,将语言转化为知识,将数据转化成智能,并做出决策。人工智能还要具备可解释性,通过模型可以解释为什么人工智能会做出这种决策,就像人类可以解释为什么会做出某种决定,可以解释为什么会认为图上的动物是狗而不是狐狸。

Cognino AI总部位于英国伦敦,在美国、巴西和印度设有办事处,专注于自学习可解释的人工智能方面,目标是用“可解释的AI”赋能决策。

帕迪说,大约10年前,也就是2010年出现了神经网络,它在面部识别和图像识别方面非常准确。过去十多年我们在人工智能方面已经取得了巨大进步,“上一波人工智能的浪潮不仅强大,而且带来了真正的变革。”

但人工智能仍然面临很多挑战。帕迪给出一张孩子拿着牙刷的图片。“为什么我很快能意识到这是一个拿着牙刷的孩子,因为作为人类,我们关注周围的环境,仔细观察我们可以看到周围有牙刷和水槽,所以这个孩子很可能拿的是牙刷。” 而如果是人工智能来识别,由于目前AI主要基于大型统计模型,AI会认为图上是一个孩子,“可能会认为是一个拿着棒棒糖的孩子,也可能会认为是一个拿着牙刷的孩子,或者可能是一个拿着勺子的孩子。”总之AI肯定会认为这是一个孩子,但无法根据周围的信息判断他拿的是什么,因此不能绝对准确地对图片上的内容进行预测。

而如果是人工智能来识别,由于目前AI主要基于大型统计模型,AI会认为图上是一个孩子,“可能会认为是一个拿着棒棒糖的孩子,也可能会认为是一个拿着牙刷的孩子,或者可能是一个拿着勺子的孩子。”总之AI肯定会认为这是一个孩子,但无法根据周围的信息判断他拿的是什么,因此不能绝对准确地对图片上的内容进行预测。

“也就是说,当涉及到个别情况时,AI有时是不可靠的。”帕迪说,他最近测试了一款有趣的食品识别应用程序,然而程序却告诉他食物拼盘图片有99%的可能性是章鱼。 “这就是目前面临的挑战。之所以判断为章鱼,是因为缺少上下文的情境信息。”帕迪说,AI不具备清晰的理解能力,不能像人类一样处理信息并将其置于情境中。“我们使用的情境是基于我们的短期记忆和长期记忆,以及我们当前学到的和过去学到的知识。”

“这就是目前面临的挑战。之所以判断为章鱼,是因为缺少上下文的情境信息。”帕迪说,AI不具备清晰的理解能力,不能像人类一样处理信息并将其置于情境中。“我们使用的情境是基于我们的短期记忆和长期记忆,以及我们当前学到的和过去学到的知识。”

相对于十多年前出现的AI浪潮,帕迪认为,在下一次浪潮中,AI必须具有感知和理解行为的能力,利用人类理解语言的能力,将语言转化为知识,将数据转化成智能,并做出决策。“我认为这才是真正的人工智能,它可以根据上下文的情境理解并采取行动。”

另一方面,人工智能还要具备可解释性,“我们需要考虑什么是有效的,什么是可追溯的,什么是可审核的。”对于可解释的AI,帕迪说,也就是通过模型可以解释为什么人工智能会做出这种决策,“每当涉及到AI时,我们都能解释模型工作的原理。”

“我们关注人工智能如何观察、学习、推理、抽象、解释,并且可以交互学习,还有短期记忆和长期记忆,就像人类那样。这样就可以通过大量真实世界的数据进行推理,并且可以做出一个可以真正解释的决定。”

帕迪说,团队正在研究下一代人工智能。他们并不通过训练数十亿的狗的图片来预测图片上是一只狗,不在大型复杂数据集的基础上学习,而是通过示范人类学习的过程让模型学习。“我们的想法是基于一组训练数据和一些基本组成元素,学习的过程是基于基本元素的。” “所以我们需要创建一个可以被训练的AI模型,这些基本元素的组合决定了狗是由什么组成的。狗由头、尾巴、四条腿和身体组成,还有两只耳朵。这些是我们需要让模型学习的各种基本元素。”

“所以我们需要创建一个可以被训练的AI模型,这些基本元素的组合决定了狗是由什么组成的。狗由头、尾巴、四条腿和身体组成,还有两只耳朵。这些是我们需要让模型学习的各种基本元素。”

团队还让场景信息发生变化,在这一过程中逐步告诉模型这是一只狗,“几乎90%的学习是通过自我学习的,因为模型理解了狗的基本组成元素。所以即使场景改变了,模型仍然可以知道这是一只狗。”

但这并没有就此结束,帕迪说,他们还必须弄清楚为什么模型会做出这样的判断,为什么模型会认为这是一只狗而不是一只狐狸,能否通过改变模型的某些特征要素来影响模型的决策。“必须将这种真实性、可审核性和解释性作为我们所构建的AI结构的基础。”

也就是说,通过引入这些基础元素和上下文的情境信息,让模型能够像人类一样学习,并随着情境的改变而不断做出调整。模型也需要具有解释的能力,就像人类可以解释为什么他们会做出某种决定,可以解释为什么他们会认为这是一张狗的照片。(本文来自澎湃新闻,更多原创资讯请下载“澎湃新闻”APP)

5月21日,英国初创公司Cognino AI联合创始人兼首席执行官普里蒂·帕迪(Priti Padhy)在第五届世界智能大会科技向善与人工智能教育论坛上通过视频表示,在下一波人工智能浪潮中,AI必须具有感知和理解行为的能力,利用人类理解语言的能力,将语言转化为知识,将数据转化成智能,并做出决策。人工智能还要具备可解释性,通过模型可以解释为什么人工智能会做出这种决策,就像人类可以解释为什么会做出某种决定,可以解释为什么会认为图上的动物是狗而不是狐狸。

Cognino AI总部位于英国伦敦,在美国、巴西和印度设有办事处,专注于自学习可解释的人工智能方面,目标是用“可解释的AI”赋能决策。

帕迪说,大约10年前,也就是2010年出现了神经网络,它在面部识别和图像识别方面非常准确。过去十多年我们在人工智能方面已经取得了巨大进步,“上一波人工智能的浪潮不仅强大,而且带来了真正的变革。”

但人工智能仍然面临很多挑战。帕迪给出一张孩子拿着牙刷的图片。“为什么我很快能意识到这是一个拿着牙刷的孩子,因为作为人类,我们关注周围的环境,仔细观察我们可以看到周围有牙刷和水槽,所以这个孩子很可能拿的是牙刷。”

而如果是人工智能来识别,由于目前AI主要基于大型统计模型,AI会认为图上是一个孩子,“可能会认为是一个拿着棒棒糖的孩子,也可能会认为是一个拿着牙刷的孩子,或者可能是一个拿着勺子的孩子。”总之AI肯定会认为这是一个孩子,但无法根据周围的信息判断他拿的是什么,因此不能绝对准确地对图片上的内容进行预测。

而如果是人工智能来识别,由于目前AI主要基于大型统计模型,AI会认为图上是一个孩子,“可能会认为是一个拿着棒棒糖的孩子,也可能会认为是一个拿着牙刷的孩子,或者可能是一个拿着勺子的孩子。”总之AI肯定会认为这是一个孩子,但无法根据周围的信息判断他拿的是什么,因此不能绝对准确地对图片上的内容进行预测。

“也就是说,当涉及到个别情况时,AI有时是不可靠的。”帕迪说,他最近测试了一款有趣的食品识别应用程序,然而程序却告诉他食物拼盘图片有99%的可能性是章鱼。

“这就是目前面临的挑战。之所以判断为章鱼,是因为缺少上下文的情境信息。”帕迪说,AI不具备清晰的理解能力,不能像人类一样处理信息并将其置于情境中。“我们使用的情境是基于我们的短期记忆和长期记忆,以及我们当前学到的和过去学到的知识。”

“这就是目前面临的挑战。之所以判断为章鱼,是因为缺少上下文的情境信息。”帕迪说,AI不具备清晰的理解能力,不能像人类一样处理信息并将其置于情境中。“我们使用的情境是基于我们的短期记忆和长期记忆,以及我们当前学到的和过去学到的知识。”

相对于十多年前出现的AI浪潮,帕迪认为,在下一次浪潮中,AI必须具有感知和理解行为的能力,利用人类理解语言的能力,将语言转化为知识,将数据转化成智能,并做出决策。“我认为这才是真正的人工智能,它可以根据上下文的情境理解并采取行动。”

另一方面,人工智能还要具备可解释性,“我们需要考虑什么是有效的,什么是可追溯的,什么是可审核的。”对于可解释的AI,帕迪说,也就是通过模型可以解释为什么人工智能会做出这种决策,“每当涉及到AI时,我们都能解释模型工作的原理。”

“我们关注人工智能如何观察、学习、推理、抽象、解释,并且可以交互学习,还有短期记忆和长期记忆,就像人类那样。这样就可以通过大量真实世界的数据进行推理,并且可以做出一个可以真正解释的决定。”

帕迪说,团队正在研究下一代人工智能。他们并不通过训练数十亿的狗的图片来预测图片上是一只狗,不在大型复杂数据集的基础上学习,而是通过示范人类学习的过程让模型学习。“我们的想法是基于一组训练数据和一些基本组成元素,学习的过程是基于基本元素的。”

“所以我们需要创建一个可以被训练的AI模型,这些基本元素的组合决定了狗是由什么组成的。狗由头、尾巴、四条腿和身体组成,还有两只耳朵。这些是我们需要让模型学习的各种基本元素。”

“所以我们需要创建一个可以被训练的AI模型,这些基本元素的组合决定了狗是由什么组成的。狗由头、尾巴、四条腿和身体组成,还有两只耳朵。这些是我们需要让模型学习的各种基本元素。”

团队还让场景信息发生变化,在这一过程中逐步告诉模型这是一只狗,“几乎90%的学习是通过自我学习的,因为模型理解了狗的基本组成元素。所以即使场景改变了,模型仍然可以知道这是一只狗。”

但这并没有就此结束,帕迪说,他们还必须弄清楚为什么模型会做出这样的判断,为什么模型会认为这是一只狗而不是一只狐狸,能否通过改变模型的某些特征要素来影响模型的决策。“必须将这种真实性、可审核性和解释性作为我们所构建的AI结构的基础。”

也就是说,通过引入这些基础元素和上下文的情境信息,让模型能够像人类一样学习,并随着情境的改变而不断做出调整。模型也需要具有解释的能力,就像人类可以解释为什么他们会做出某种决定,可以解释为什么他们会认为这是一张狗的照片。(本文来自澎湃新闻,更多原创资讯请下载“澎湃新闻”APP)

热门手游下载

天天绕圈圈游戏 1.2.5 安卓版

天天绕圈圈游戏 1.2.5 安卓版 加查海关与咖啡游戏 1.1.0 安卓版

加查海关与咖啡游戏 1.1.0 安卓版 大吉普越野驾驶游戏 1.0.4 安卓版

大吉普越野驾驶游戏 1.0.4 安卓版 沙盒星球建造游戏 1.5.0 安卓版

沙盒星球建造游戏 1.5.0 安卓版 秘堡埃德兰Elderand游戏 1.3.8 安卓版

秘堡埃德兰Elderand游戏 1.3.8 安卓版 地铁跑酷暗红双旦版 3.5.0 安卓版

地铁跑酷暗红双旦版 3.5.0 安卓版 跨越奔跑大师游戏 0.1 安卓版

跨越奔跑大师游戏 0.1 安卓版 Robot Warfare手机版 0.4.1 安卓版

Robot Warfare手机版 0.4.1 安卓版 地铁跑酷playmods版 3.18.2 安卓版

地铁跑酷playmods版 3.18.2 安卓版 我想成为影之强者游戏 1.11.1 官方版

我想成为影之强者游戏 1.11.1 官方版 gachalife2最新版 0.92 安卓版

gachalife2最新版 0.92 安卓版 航梦游戏编辑器最新版 1.0.6.8 安卓版

航梦游戏编辑器最新版 1.0.6.8 安卓版 喵星人入侵者游戏 1.0 安卓版

喵星人入侵者游戏 1.0 安卓版 地铁跑酷黑白水下城魔改版本 3.9.0 安卓版

地铁跑酷黑白水下城魔改版本 3.9.0 安卓版

相关文章

- 猜一猜以下哪种职业可以让人工智能更好地为人类服务 蚂蚁新村今日答案最新11月26日

- 算法新闻汇编|《人工智能担当宣言》发布,谷歌自主开发芯片

- AI寻药:星药科技新融资,上海人工智能产业投资基金领投

- “魔都结界”背后的人工智能:新技术如何提升城市软实力

- 何积丰院士:人工智能需要规则性治理

- 人工智能技术最佳试验场:把人民城市理念落实到每一条小马路

- 速览|世界人工智能大会圆满落幕,最后一天嘉宾们讨论些啥?

- 世界人工智能大会圆满落幕,上海向全球AI有识之士发邀请函

- 全国数据交易联盟今日在世界人工智能大会上正式成立

- 上海市人工智能标准化技术委员会成立,近期完成标准体系编制

- 专访上海人工智能研究院CTO:探索新基建下的AI技术落地

- 速览|世界人工智能大会第二天思想激荡继续,金句集锦来了

热门文章

- 1 小米手环充电没反应怎么办 小米手环无法充电解决方法

- 2 20余科学家发文称新冠病毒不可能是人为制造,专访第一作者

- 3 深圳灵明光子发布自主研发3D传感芯片,初步具备量产能力

- 4 万乘基因发布高通量单细胞测序仪,打破海外垄断国内市场现状

- 5 中国科学家提出一种新型固态原子钟方案,更适于实际应用

- 6 中国首个原创抗体偶联药物“出海”:交易额创纪录26亿美元

- 7 小米手环2闹钟怎么关闭 闹钟每隔10分钟就响一次解决方法

- 8 为何飞了这么久才到?落火之后做什么?设计师揭秘天问一号

- 9 这家上海机器人公司凭啥拿下丰田大单?背后有40年研发基因

- 10 科技部等多部门:支持女性科技人才在科技创新中发挥更大作用

热门手游推荐

换一批

- 1

芭比公主宠物城堡游戏 1.9 安卓版

- 2

死神之影2游戏 0.42.0 安卓版

- 3

地铁跑酷忘忧10.0原神启动 安卓版

- 4

跨越奔跑大师游戏 0.1 安卓版

- 5

挂机小铁匠游戏 122 安卓版

- 6

咸鱼大翻身游戏 1.18397 安卓版

- 7

灵魂潮汐手游 0.45.3 安卓版

- 8

烤鱼大师小游戏 1.0.0 手机版

- 9

旋转陀螺多人对战游戏 1.3.1 安卓版

- 10

Escapist游戏 1.1 安卓版

- 1

开心消消乐赚钱版下载

- 2

Minecraft我的世界基岩版正版免费下载

- 3

暴力沙盒仇恨最新版2023

- 4

疯狂扯丝袜

- 5

黑暗密语2内置作弊菜单 1.0.0 安卓版

- 6

爆笑虫子大冒险内购版

- 7

姚记捕鱼

- 8

秘密邻居中文版

- 9

班班幼儿园手机版

- 10

千炮狂鲨

芭比公主宠物城堡游戏 1.9 安卓版

芭比公主宠物城堡游戏 1.9 安卓版 死神之影2游戏 0.42.0 安卓版

死神之影2游戏 0.42.0 安卓版 地铁跑酷忘忧10.0原神启动 安卓版

地铁跑酷忘忧10.0原神启动 安卓版 挂机小铁匠游戏 122 安卓版

挂机小铁匠游戏 122 安卓版 咸鱼大翻身游戏 1.18397 安卓版

咸鱼大翻身游戏 1.18397 安卓版 灵魂潮汐手游 0.45.3 安卓版

灵魂潮汐手游 0.45.3 安卓版 烤鱼大师小游戏 1.0.0 手机版

烤鱼大师小游戏 1.0.0 手机版 旋转陀螺多人对战游戏 1.3.1 安卓版

旋转陀螺多人对战游戏 1.3.1 安卓版 Escapist游戏 1.1 安卓版

Escapist游戏 1.1 安卓版 开心消消乐赚钱版下载

开心消消乐赚钱版下载 Minecraft我的世界基岩版正版免费下载

Minecraft我的世界基岩版正版免费下载 暴力沙盒仇恨最新版2023

暴力沙盒仇恨最新版2023 疯狂扯丝袜

疯狂扯丝袜 黑暗密语2内置作弊菜单 1.0.0 安卓版

黑暗密语2内置作弊菜单 1.0.0 安卓版 爆笑虫子大冒险内购版

爆笑虫子大冒险内购版 姚记捕鱼

姚记捕鱼 秘密邻居中文版

秘密邻居中文版 班班幼儿园手机版

班班幼儿园手机版 千炮狂鲨

千炮狂鲨