如何在本地部署最先进的开源大模型Llama3

扫描二维码随身看资讯

使用手机 二维码应用 扫描右侧二维码,您可以

1. 在手机上细细品读~

2. 分享给您的微信好友或朋友圈~

你是否曾因无法使用ChatGPT而感到苦恼?或者即使访问了ChatGPT,也无法使用GPT4?现在,一切问题都可以迎刃而解了!

4月18日,Meta发布了两款开源模型Llama 3 8B和Llama 3 70B,供外部开发者免费使用。这一消息在全球开发者中掀起了轩然大波。据Meta称,Llama 3 8B和Llama 3 70B是目前同等规模下性能最优秀的开源模型。

因此,Llama3成为了ChatGPT的最佳替代品。

本文将一步一步教你如何在本地部署目前最先进的开源大模型Llama3,让你不再受网络问题困扰,并且可以无限制地使用大模型。非常简单,包教包会。

首先,让我介绍一下作者的开发环境: 内存 32G,显存22G,Windows

1. 安装docker

什么是docker?

简单来说,你可以将docker理解为轻量级的虚拟机。也许你曾经遇到过,使用某个软件时环境不兼容,还需要安装各种依赖,这经常导致卡在某一步无法继续。因此,容器化技术很好地解决了这个问题,它能够将你需要的环境、以及所需的依赖等打包成镜像,使你能够在容器中直接运行。

首先,访问 docker官网 ,下载docker桌面版。

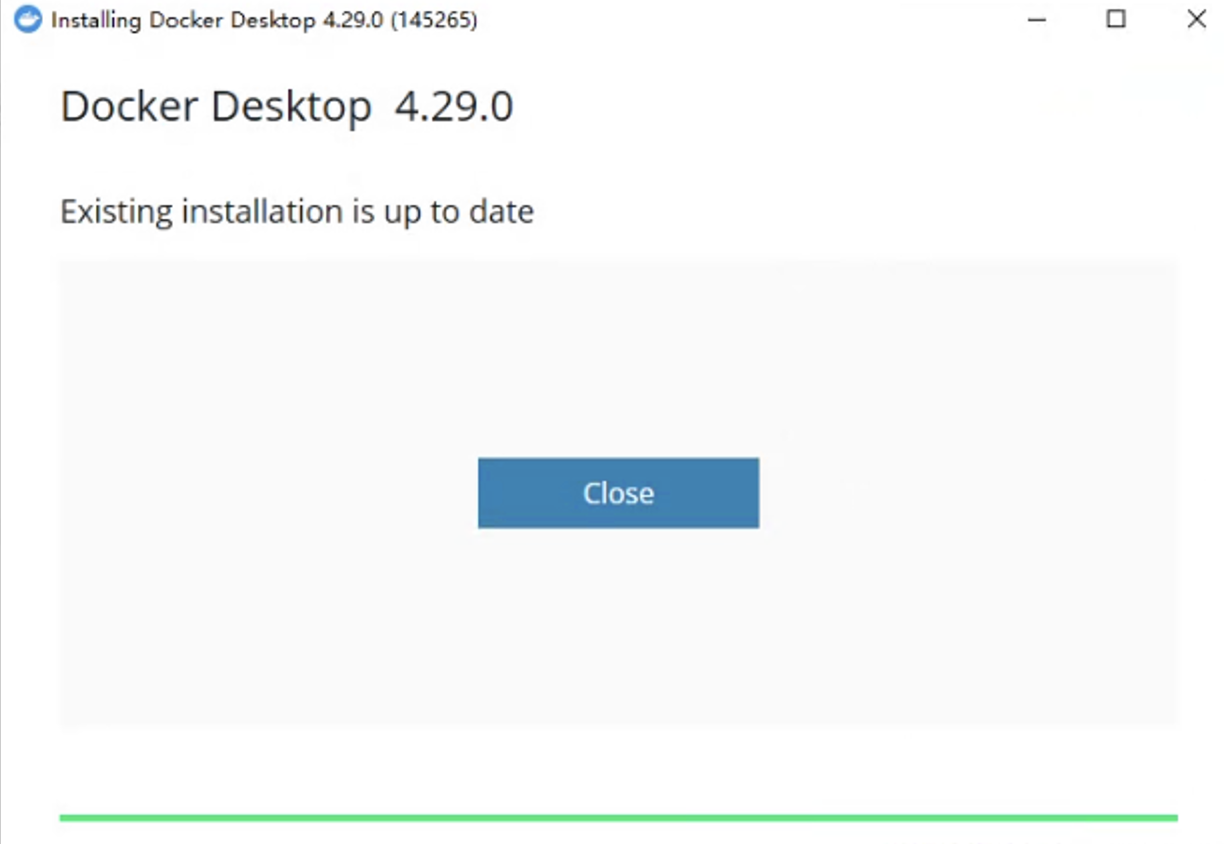

下载完成后,双击直接安装。

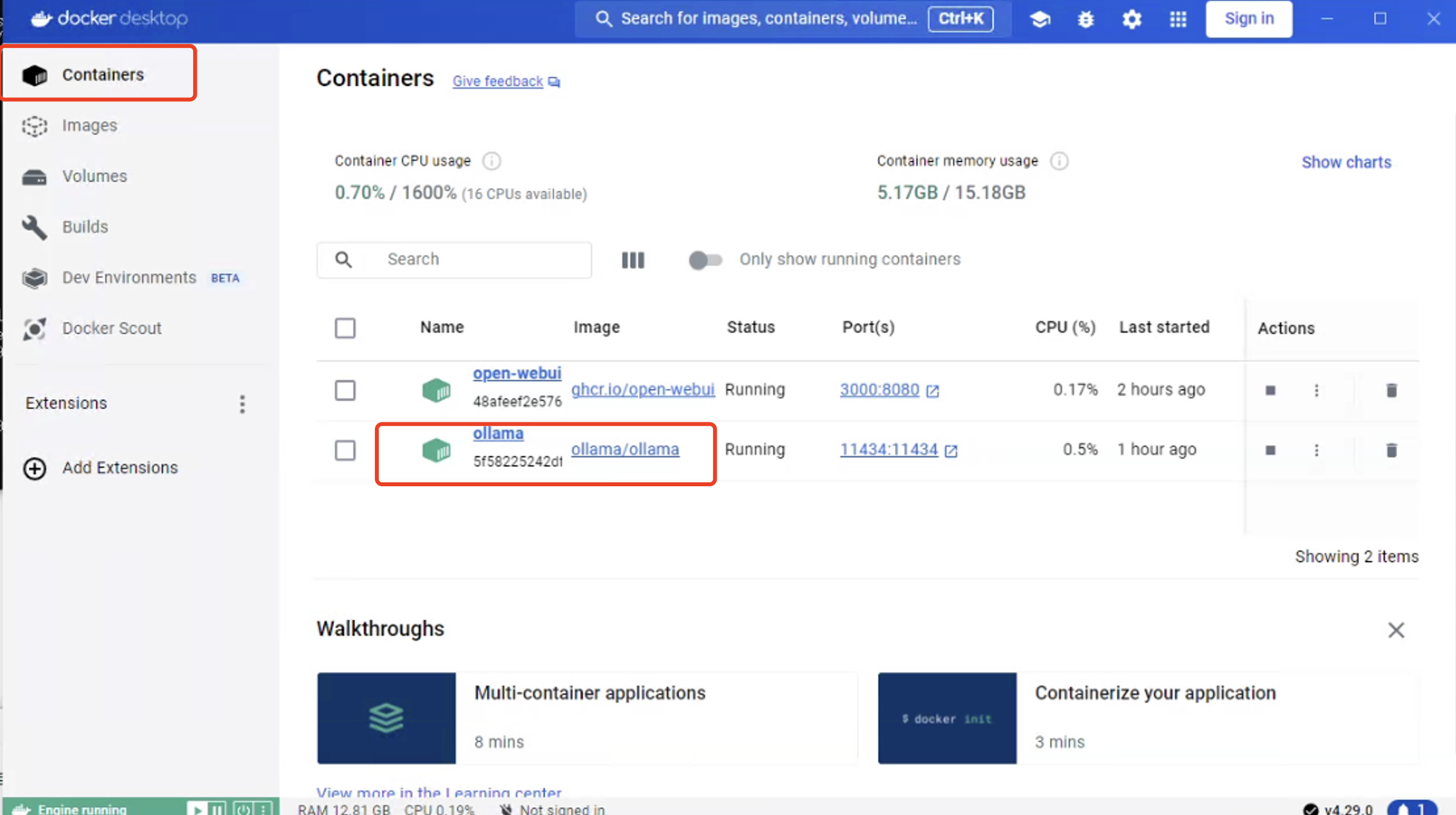

上述图片显示我已成功安装。

2. 安装ollama

随着LLM的迅速发展,一些优秀的开源大语言基座模型得到了广泛应用。例如Meta发布的Llama3和Google发布的Gemma等。每次大模型的发布都宣称是有史以来最强的,但只有亲自体验过才能知晓其真正效果。

Ollama就是为此而设计,让你能够快速在本地部署各种大模型。

Ollama可以直接部署在本地,也可以部署在docker上,但为了简便起见,我们选择在docker上部署。

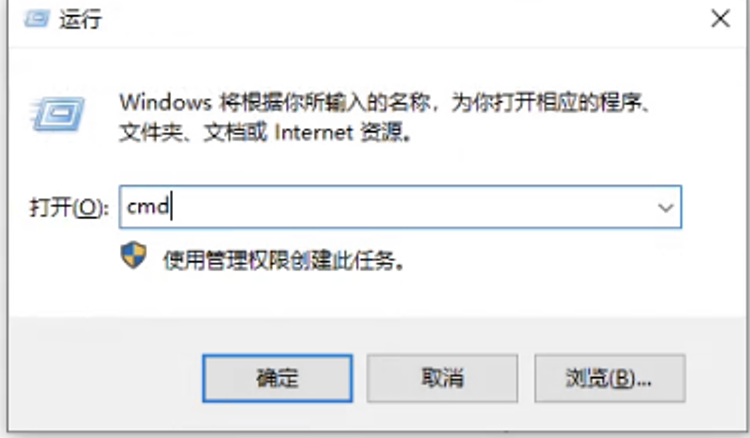

首先打开Windows命令行,可使用win+r,然后输入cmd来打开。

然后输入以下命令

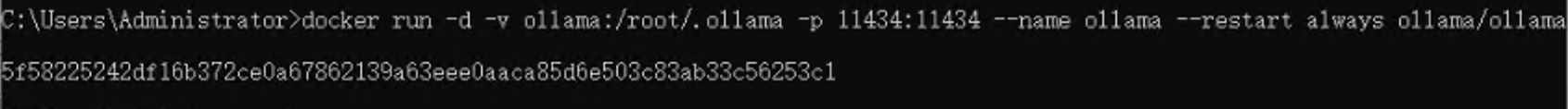

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama --restart always ollama/ollama

如果没有ollama镜像,将会自动从网络获取ollama镜像。

我已经安装过了。

小贴士:最好使用命令行运行,主要是为了打开11434端口,为后续可视化做准备。

3. 安装llama3模型

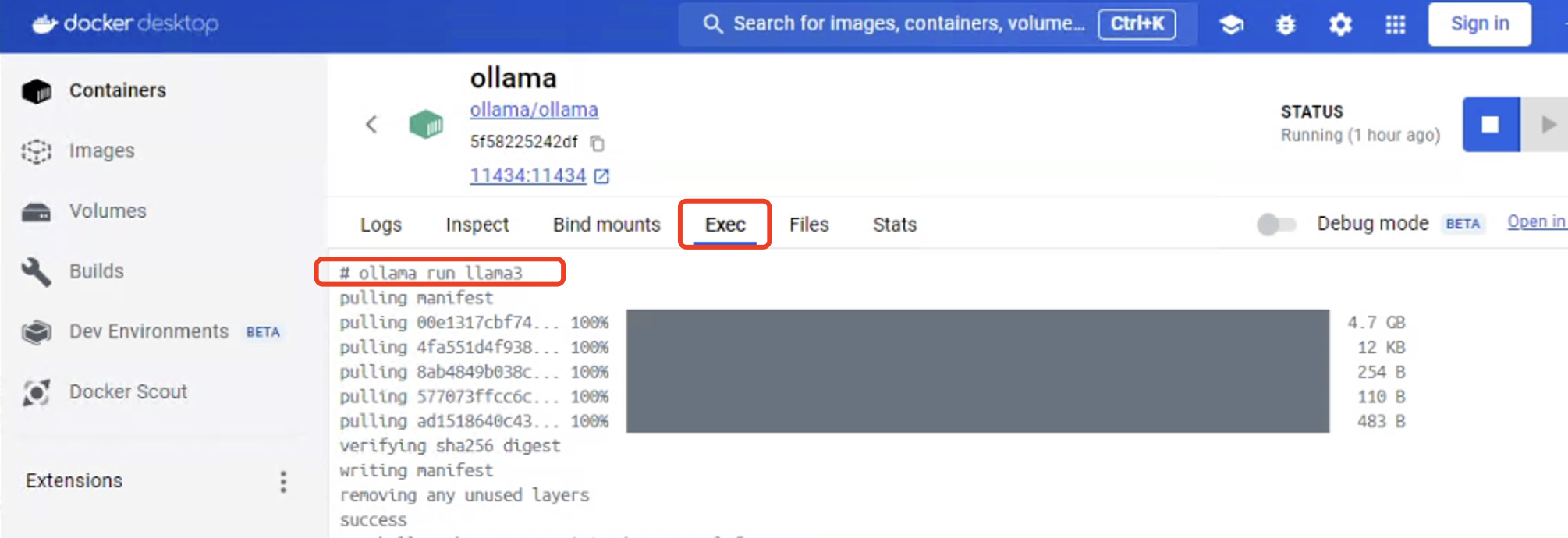

在docker desktop中找到ollama的容器,点击进入。

点击exec进入容器命令行。

运行以下命令

ollama run llama3

ollama会自动下载llama3模型并运行。

等待下载完成后,显示success便是运行成功,这时就可以开始向它提问了。

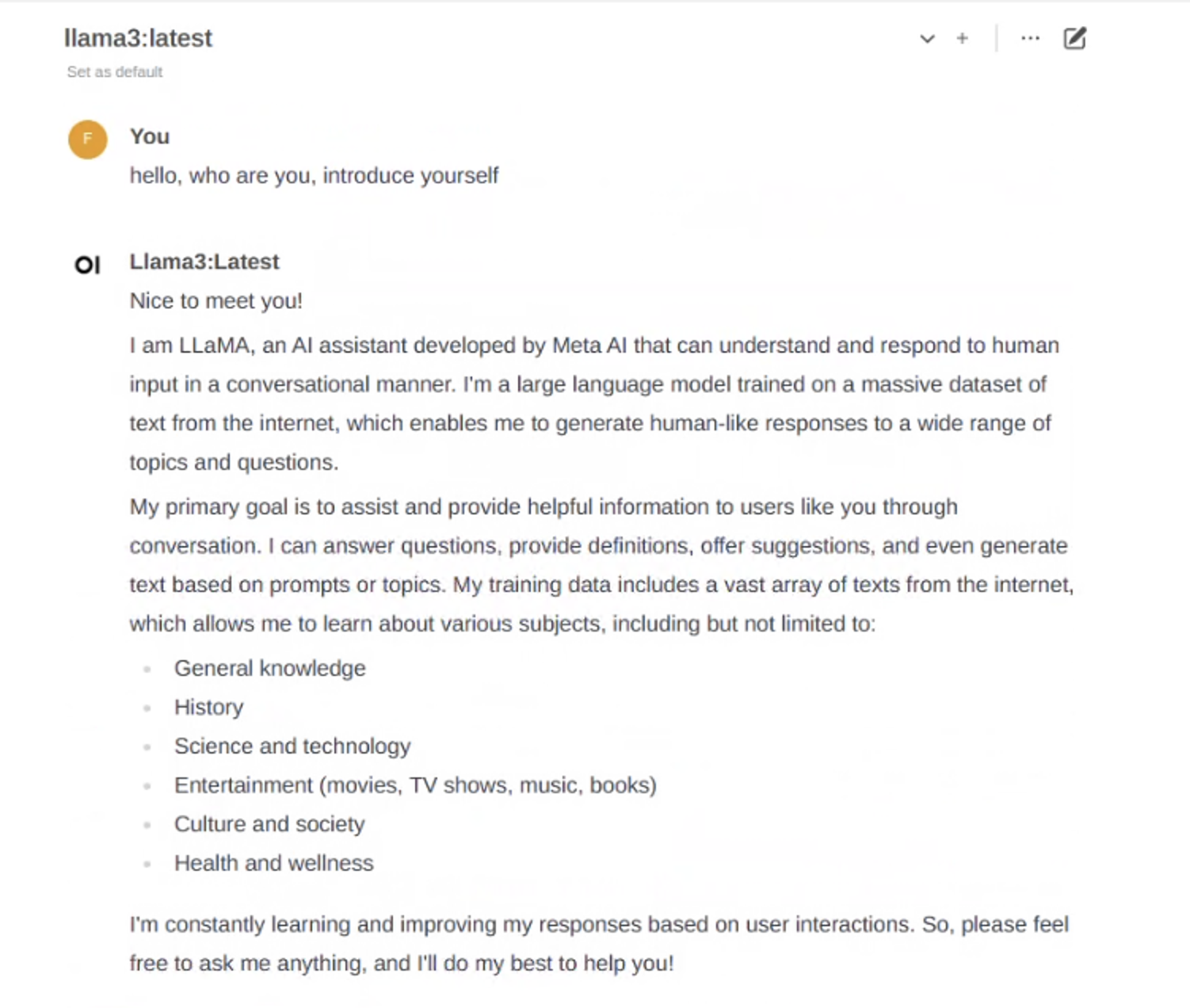

上面是我向它提的问题,可以看到已经有了回答。

4. 安装Open WebUI

虽然大模型已经安装成功,但总不能一直使用命令行来提问吧,这样非常不友好。那么该怎样才能像ChatGPT那样呢?

别担心,开源社区总会给我们带来惊喜,Open WebUI就是为此而设计的。

打开命令行,执行以下命令。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

如果没有镜像,将会自动下载Open WebUI的镜像,然后执行。

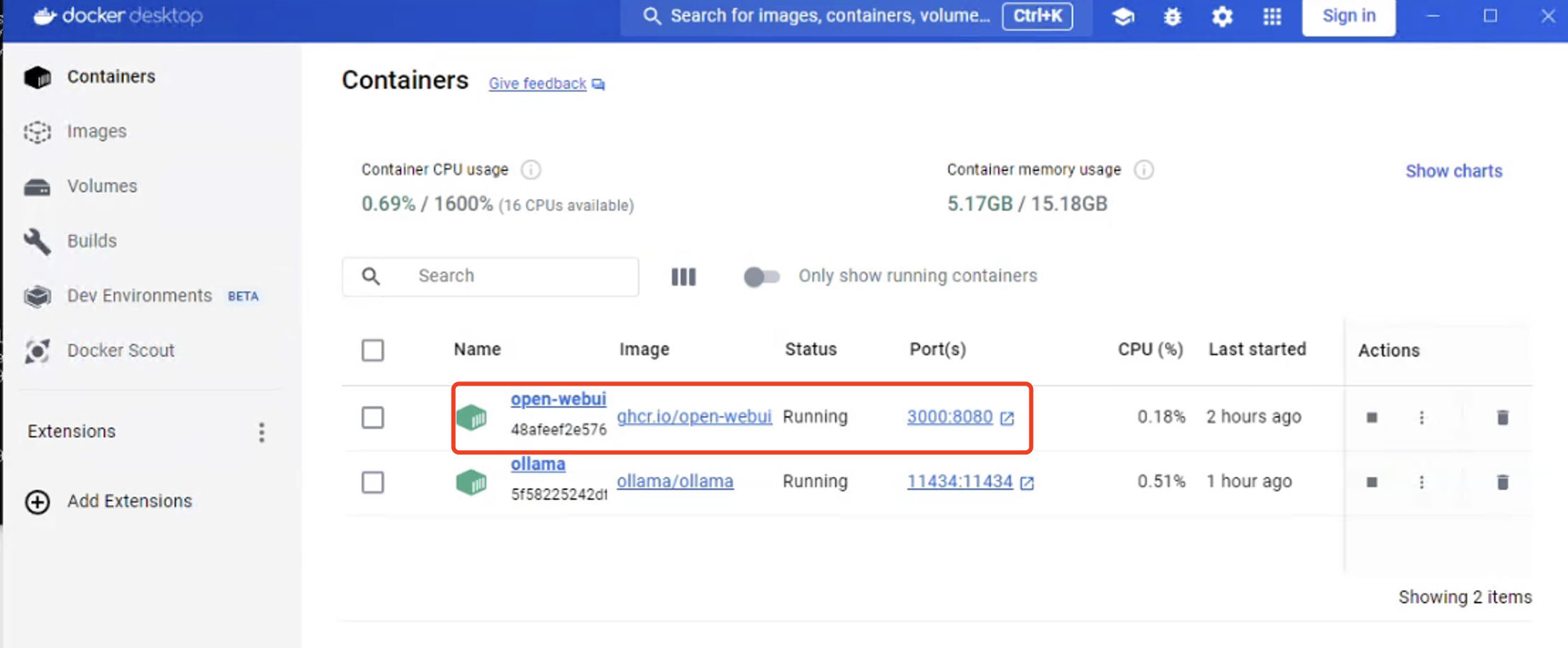

这时你可以打开docker desktop,就能看到open-webui已经在运行中。

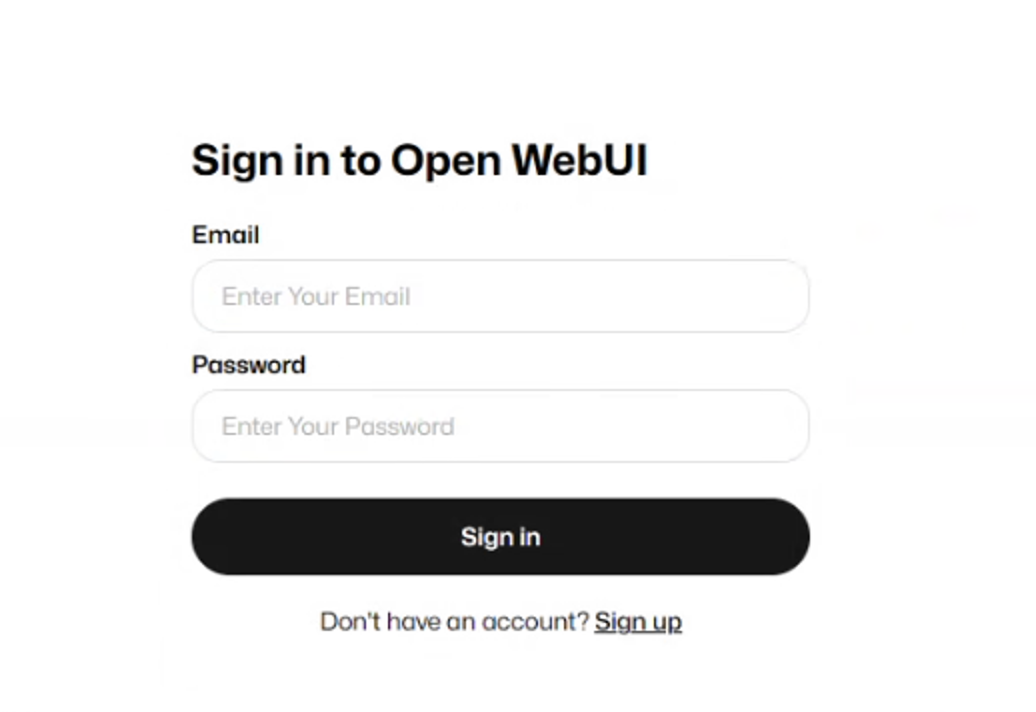

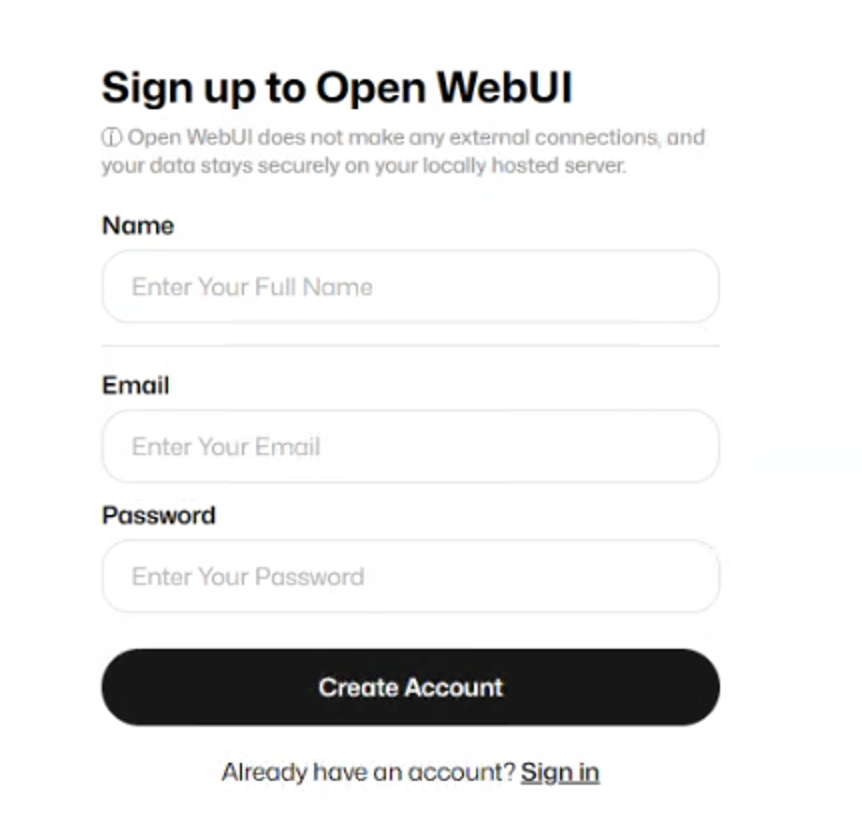

打开浏览器,输入localhost:3000,若出现登录界面,就表示安装成功。

可以注册一个账号再登录。

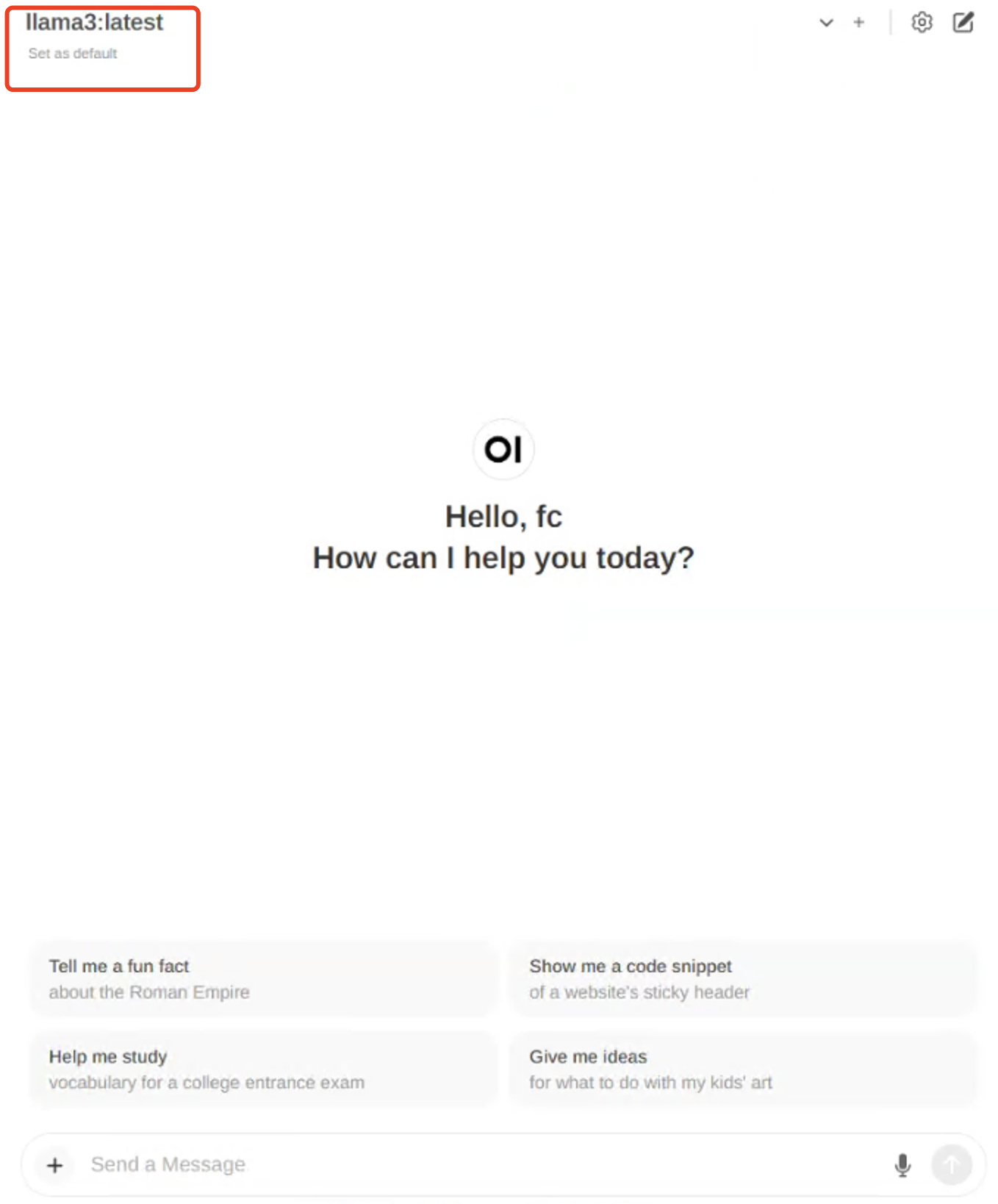

还需要在上面设置模型后才能使用。

选择刚刚创建好的llama3,这样就可以开始提问了。

到此为止,你已经成功拥有了自己的ChatGPT,尽情享受你的Llama3吧。

结束

今后,我将持续分享与AI相关的技术,欢迎大家关注。

如果在安装过程中遇到任何问题,也欢迎提问,我将非常乐意为你解答。

- 1

加查之花 正版

- 2

爪女孩 最新版

- 3

企鹅岛 官方正版中文版

- 4

捕鱼大世界 无限金币版

- 5

球球英雄 手游

- 6

情商天花板 2024最新版

- 7

内蒙打大a真人版

- 8

烦人的村民 手机版

- 9

跳跃之王手游

- 10

蛋仔派对 国服版本

加查之花 正版

加查之花 正版 爪女孩 最新版

爪女孩 最新版 企鹅岛 官方正版中文版

企鹅岛 官方正版中文版 捕鱼大世界 无限金币版

捕鱼大世界 无限金币版 球球英雄 手游

球球英雄 手游 情商天花板 2024最新版

情商天花板 2024最新版 内蒙打大a真人版

内蒙打大a真人版 烦人的村民 手机版

烦人的村民 手机版 跳跃之王手游

跳跃之王手游 蛋仔派对 国服版本

蛋仔派对 国服版本 黑暗密语2内置作弊菜单 1.0.0 安卓版

黑暗密语2内置作弊菜单 1.0.0 安卓版 驱动事务游戏汉化版 0.3.5 安卓版

驱动事务游戏汉化版 0.3.5 安卓版 地铁跑酷忘忧10.0原神启动 安卓版

地铁跑酷忘忧10.0原神启动 安卓版 猫落家伙最新版 1.4 安卓版

猫落家伙最新版 1.4 安卓版 芭比公主宠物城堡游戏 1.9 安卓版

芭比公主宠物城堡游戏 1.9 安卓版 挂机小铁匠游戏 122 安卓版

挂机小铁匠游戏 122 安卓版 咸鱼大翻身游戏 1.18397 安卓版

咸鱼大翻身游戏 1.18397 安卓版 无尽对决国际服最新版本 1.7.70.8402 安卓版

无尽对决国际服最新版本 1.7.70.8402 安卓版 跨越奔跑大师游戏 0.1 安卓版

跨越奔跑大师游戏 0.1 安卓版 火影忍者云游戏版最新版 4.7.1.3029701 安卓版

火影忍者云游戏版最新版 4.7.1.3029701 安卓版